Transparente KI-Agenten: Warum Vertrauen jetzt messbar werden muss

KI-Agenten treffen täglich eigenständig Entscheidungen: ohne Transparenz, klare Kontrollmechanismen und Audit-Trails werden sie zur Compliance- und Sicherheitslücke, weshalb Unternehmen jetzt Governance, Guardrails und überprüfbare Prüfprozesse etablieren müssen.

Dein KI-Agent trifft 100 Entscheidungen am Tag. Wie viele davon kannst du nachvollziehen?

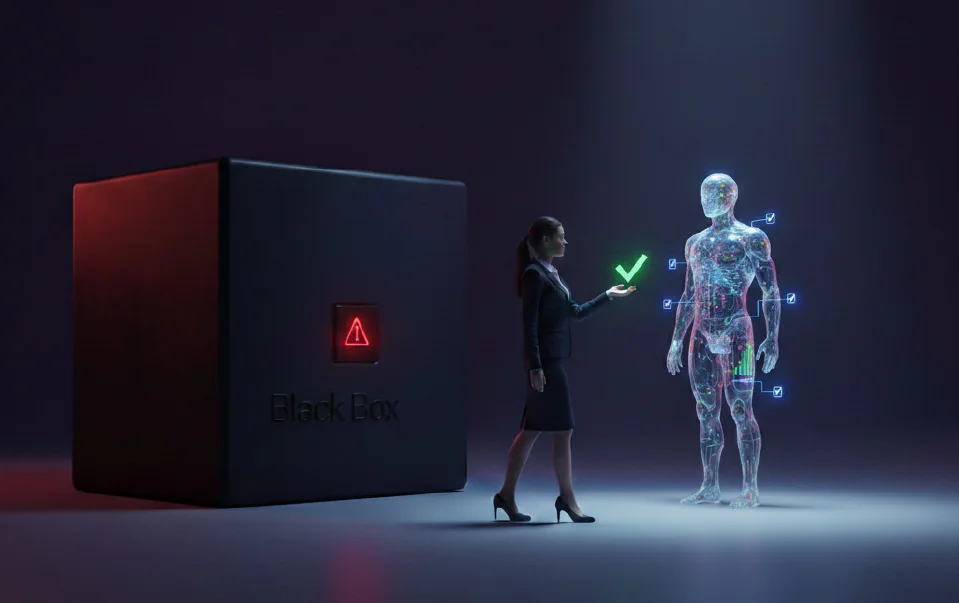

Wenn du jetzt zögerst, bist du nicht allein. Die meisten Unternehmen haben längst Agenten im Einsatz – Copilot hier, ChatGPT dort, ein Bot im Ticketsystem, einer im CRM. Was nach Produktivität aussieht, ist oft eine Blackbox mit Schreibrechten.

Das unsichtbare Problem

KI-Agenten sind keine passiven Chatbots mehr. Sie klicken, lesen, schreiben, versenden Daten. Sie greifen auf Tools zu, führen Aktionen aus, treffen Entscheidungen. Und das alles, während niemand so genau hinschaut.

Eine aktuelle Apple-Studie bringt es auf den Punkt: Nutzer wollen keine mächtige Blackbox. Sie wollen Transparenz und Kontrolle. Lieber ein Agent, der weniger kann, aber dessen Handeln nachvollziehbar ist – als ein Turbo-Automat, dem man blind vertrauen muss.

Das ist kein Luxuswunsch. Ab August 2026 wird es zur Pflicht. Der EU AI Act macht Transparenz zur harten Anforderung: Dokumentation, Nachvollziehbarkeit, Prüfpfade. Wer das nicht liefern kann, riskiert Bußgelder und Marktausschluss.

Warum Bauchgefühl nicht reicht

„Der Agent macht das schon richtig" – dieser Satz ist das neue „Das haben wir schon immer so gemacht."

Ein Agent kann überzeugend wirken und trotzdem falsch liegen. Er kann plausible Texte produzieren, die sachlich daneben sind. Er kann Aktionen ausführen, die niemand autorisiert hat. Das klassische Muster: Prompt rein, Output raus, merge. Ohne echtes Review. Ohne Verständnis, was dazwischen passiert ist.

Die Zahlen sprechen eine deutliche Sprache: 48 Prozent der Sicherheitsexperten sehen Agentic AI als den wichtigsten Angriffsvektor für 2026. Nicht weil die Modelle schlecht sind. Sondern weil die Kontrolle fehlt.

Vier Wege, KI-Agenten überprüfbar zu machen

1. Agent-as-Judge: Wenn KI die KI prüft

Die Idee klingt paradox, funktioniert aber: Ein zweites Modell bewertet die Outputs des ersten. Skalierbar. Rund 80 Prozent Übereinstimmung mit menschlichem Urteil.

Neue Forschung geht noch weiter. Agent-as-Judge-Systeme nutzen nicht nur ein Sprachmodell, sondern Agenten mit Tool-Zugriff, Planung und Gedächtnis. Sie können Fakten nachschlagen, Ergebnisse verifizieren, Widersprüche aufdecken. Robuster als ein reiner LLM-Richter, der nur auf den Text schaut.

2. Formale Guardrails: Grenzen setzen, bevor es kracht

Nicht jeder Agent braucht Zugriff auf alles. Tool-Allowlists definieren, welche Aktionen erlaubt sind. Least Privilege heißt: nur das Minimum an Rechten. DLP-Muster fangen sensible Daten ab, bevor sie rausfließen. Secrets-Schutz verhindert, dass API-Keys oder Passwörter im Kontext landen.

Klingt nach Basics. Wird trotzdem ständig vergessen.

3. Audit-Trails: Jede Aktion protokollieren

Nicht nur das Ergebnis zählt. Sondern auch der Weg dorthin. Welche Tools hat der Agent aufgerufen? Welche Zwischenschritte? Welche Entscheidungen?

Unveränderliche Prüfpfade sind kein Nice-to-have mehr. Sie sind Compliance-Anforderung. Und im Ernstfall der einzige Weg, um nachzuvollziehen, was schiefgelaufen ist.

4. Red-Team-Tests: Angreifen, bevor andere es tun

Prompt Injection ist real. Manipulierte Kontexte sind real. Wer seine Agenten nicht aktiv testet, erfährt von der Schwachstelle erst durch den Vorfall.

Red-Teaming heißt: den Agenten unter Stress setzen. Unerwartete Inputs. Manipulierte Daten. Grenzfälle. Lieber jetzt im Test scheitern als später in Produktion.

Der Plan: Agenten wie Externe behandeln

Stell dir vor, du stellst einen neuen Mitarbeiter ein. Du gibst ihm nicht sofort Zugriff auf alles. Du definierst Rollen, Freigaben, Verantwortlichkeiten. Du machst ein Review, bevor kritische Entscheidungen rausgehen.

Genau so solltest du Agenten behandeln.

- Policies definieren: Was darf der Agent? Was nicht?

- Freigaben einführen: Riskante Aktionen brauchen Bestätigung.

- Observability einbauen: Nicht nur Outputs überwachen, sondern Aktionen.

- Governance etablieren: Ein Gremium, das KI-Einsätze bewertet und freigibt.

Kein Safety Blueprint, kein neuer Bot. So einfach ist die Regel.

Fazit: Transparenz wird zum Wettbewerbsvorteil

Transparenz ist kein Feature, das man irgendwann nachliefert. Sie wird zur Compliance-Anforderung. Und für die, die früh handeln: zum echten Vorteil.

Unternehmen, die heute Überprüfbarkeit einbauen, sparen sich morgen das Audit-Drama. Sie können Kunden zeigen, dass ihre KI kein Blindflug ist. Und sie schlafen besser, weil sie wissen, was ihre Agenten tun.

Die Frage ist nicht mehr, ob du deine Agenten kontrollieren solltest. Die Frage ist: Wie schnell kannst du anfangen?

Wie überprüft ihr heute eure KI-Agenten – per Bauchgefühl, automatisierte Tests oder gar nicht?

Quellen: