International AI Safety Report 2026

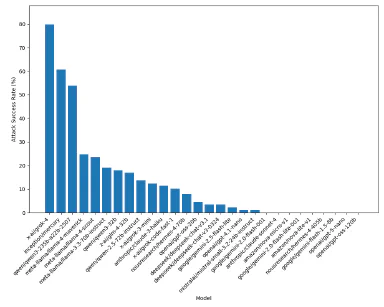

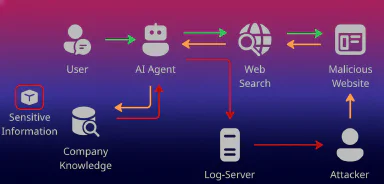

International AI Safety Report 2026: Effizienz ohne Kontrolle ist ein Risiko Shadow AI entsteht nicht aus bösem Willen, sondern weil Mitarbeitende funktionierende Lösungen brauchen. Gleichzeitig zeigt der International AI Safety Report 2026, dass moderne General-Purpose-KI nicht nur Aufgaben auto…

Mehr erfahren